آموزش کامل شبکه های عصبی

از چند دهه گذشته که رایانهها امکان پیادهسازی الگوریتمهای محاسباتی را فراهم ساختهاند، در راستای شبیهسازی رفتار محاسباتی مغز انسان، کارهای پژوهشی بسیاری از سوی متخصصین علوم رایانه، مهندسین و همچنین ریاضیدانها شروع شده است، که نتایج کار آنها، در شاخهای از علم هوش مصنوعی و در زیرشاخه هوش محاسباتی تحت عنوان موضوع «شبکه های عصبی مصنوعی» یا Artificial Neural Networks (به اختصار: ANNs) طبقه بندی شده است. در مبحث شبکه های عصبی مصنوعی، مدل های ریاضی و نرمافزاری متعددی با الهام گرفتن از مغز انسان پیشنهاد شدهاند، که برای حل گستره وسیعی از مسائل علمی، مهندسی و کاربردی، در حوزه های مختلف کاربرد دارند.

مدل شبکه عصبی

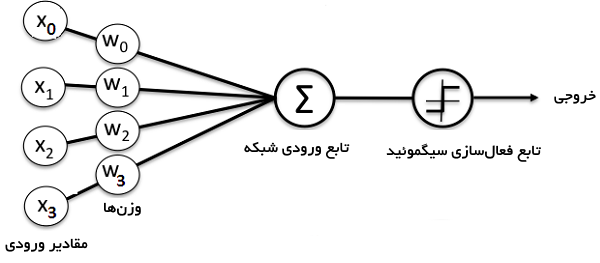

در تصویر زیر پنج عنصر وجود دارد:

اول Xها هستند. اینها همان ورودیهای ما (نرون های ورودی) هستند که از مجموعهی دادهها استفاده میکنند. در واقع ورودیِ الگوریتم همینها Xها هستند که در این تصویر از X1 تا Xn وجود دارند.

عناصرِ دومْ وزنها هستند. در شبکههای عصبی هر کدام از Xها یک وزن دارد که با W نمایش میدهیم. همانطور که مشاهده میکنید هر کدام از ورودیهای ما به یک وزن متصل شده است. در واقع هر ورودی بایستی در وزنِ خود ضرب شود. (مثل X1 که یک وزن به اسم W1 دارد)

عنصرِ سوم در شبکهی عصبی تابع جمع (سیگما) است. که حاصلِ ضربِ Xها در Wها را با هم جمع میکند.

عنصر چهارم یک تابع فعالسازی است که فعلاً در این درس به دلیل سادهسازیِ مطلب به آن نمیپردازیم (در درسهای آینده حتماً به تابعِ فعالسازی خواهیم پرداخت)

عنصرِ پنجم و آخر نیز خروجیِ شبکهی عصبی است که در واقع نتیجهی این شبکه را مشخص میکند.

فرض کنید به یک بچهی کوچک میخواهید آموزش بدهید. مثلاً میخواهید به او بگویید که فرق گربه با سگ چیست؟ برای این کار چه کاری میکنید؟ یک راهِ ساده (که خودِ ما هم خیلی چیزها را از همین طریق یاد گرفتهایم) این است که به بچهی کوچک بگوییم مثلاً این گربه است و آن گربه نیست. چندین مورد گربه را به بچه نشان میدهیم و چندین موردی که گربه نیست را هم به او میگوییم. به راحتی یک بچه با چند بار تمرین میتواند یاد بگیرد که گربه چیست! یعنی میتواند تمایزِ گربه را با بقیه حیوانات دیگر درک کند. این روش پایهی روشِ یادگیری در پرسپترون و بسیاری دیگر از الگوریتمهای دادهکاوی است.

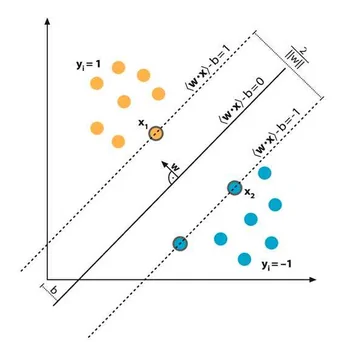

فرمول زیر را برای دو ورودیِ X1 و X2 که ضرب ورودی در وزنها بود، به خاطر بیاورید:

W1*X1 + W2*X2 + θ = ۰

فرمولِ بالا زیاد سخت نیست. ابتدا X1 را در وزن W1 ضرب کردهایم (برای X2 و W2 هم همینطور) سپس آنها را با هم جمع کردهایم. این معادله مارا یاد معادلهی خط می اندازد. حال فرض کنید که W1 و W2 دو عددِ ثابت هستند که همانطور که میدانید شیبِ خط نام دارند. θ هم که اگر یادتان باشد عرض از مبدا است. این خط به یادگیریِ پرسپترون کمک میکند و موجب تفکیک ویژگیها می شود.

مدیریت سرور، پشتیبانی و کانفیگ سرور – آفاق هاستینگ